Nej, vem förstår hur färgrymderna fungerar?

Jag tror att det är ett av de allra svåraste koncepten i begreppsbildningen kring fotografering, vilket inte minst den här tråden visar. Det är väldigt många bollar att hålla i luften för att kanske bara lite grann förstå hur färg alls fungerar.

Om man har en bakgrund i fysik är det kanske en aning lättare, men gåtor av det slag som den här tråden handlar om finns ändå. Vi har ett väldigt begränsat utrymme för färger i återgivningen, där bildskärmen har en maximalt röd, grön och blå, som när vi blandar dem blir vit. Inte lika vit som den vi kan se på den vita solbelysta fönsterkarmen, främst för att vi inte kan få sådan lyskraft i skärmen, men ändå med färgkoordinater som överensstämmer, och om vi kunde återge starkare ljus i skärmen, skulle vi kunna få fram vitt.

Men det gäller ju inte de enskilda färgerna, eftersom vi aldrig överhuvudtaget kan få fram spektralfärgerna som ligger emellan de grundfärger som vi blandar, och där ligger ett av problemen som vi överbryggar genom att godta en mindre exakt återgivning.

Vi har inte ens begrepp för det som dyker upp i färgrymden, även om vi ganska väl kan definiera ett färgomfång. Rymd och omfång är inte heller riktigt samma sak.

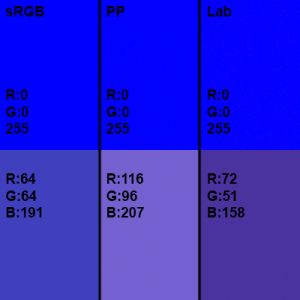

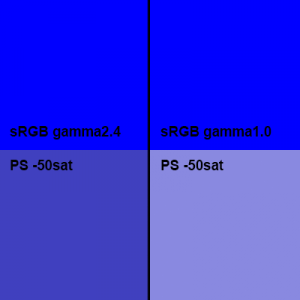

Så välkommen i gänget Idn99. Jag förstår inte heller helt och hållet, och jag tvivlar på att någon alls gör det. Men så länge vi håller oss inom omfång som kan återges av en bildskärm, kan det vara bra att komma ihåg att alla tre grundfärgerna tillsammans bildar vitt, och när en blandfärg med två färger får ett tillskott av den tredje, minskar mättnaden ytterligare. När den tredje grundfärgen förs till, spär vi ut med vitt. En lila ton som får lite mer grönt glider kanske över mot rosa, eller i alla fall malvafärg. Om vi redan har lagt dit maximalt med blått och rött, kan vi inte få mer av de färgerna, så allt tillskott av grönt kommer att dra den mot vitt.

Och svart finns inte alls. Åtminstone inte om man inte ser en lampa som en

"dark sucker".