PMD

Aktiv medlem

Jag tycker att alla som är intresserad av hur diffraktion påverkar en digitalkamera ska titta på websidan jag refererade till på förra sidan (Cambridge in Colour). Det är mycket illustrativt att använda den interaktiva grunkan (man får bläddra ner lite, men läs gärna texten från början) där man kan välja pixelstorlek och bländare varpå man kan få en aha-upplevelse när man förstår effekten av att Airyskivan täcker mer än en pixel.Vill du verkligen experimentera med skärpning är ju trots allt gamla Photoshop ett bra ställe att börja, där har du ju ett urval av både färdiga skärpningsverktyg och välkända skärpningsmetoder (sök på Youtubesom arbetar på lite olika sätt och kan kombineras närmast i det oändliga.

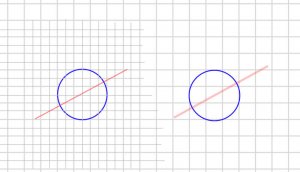

Jämför Canon EOS-1D med Sony RX100 vid bländare f/11 t.ex.