För första gången på länge har jag haft en så späckad helg att enda gången jag startat datorn har varit för att tanka av minneskorten... (och nu har jag att göra i veckan med framkallningsarbetet...)

Emils sida innehåller egentligen bara ett (1) direkt faktafel, och det är när han jämställer elektroner med fotoner i FWC. Detta gör man för bekvämlighets skull, och det är ganska allmänt accepterat att göra så (men likväl fel - det ger en snedvriden bild av skeendet och förlustfaktorerna i sensorn).

I övrigt så stämmer ekvationerna som du hänvisar till med länken,

Men med vissa inskränkningar som han väljer att inte nämna!:

Nerskalningsmodellen han hänvisar till (och använder) stämmer perfekt rent teoretiskt, men bara om man använder en matematiskt och geometriskt perfekt "binning" eller värdesaddering innan Bayerinterpolering. Försöker man återskapa resultat enligt den modellen på en verklig, färdiginterpolerad bild misslyckas man ganska rejält. Som matematisk modell är det korrekt, men det går tyvärr inte att översätta till ett verkligt resultat.

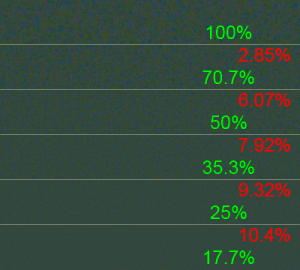

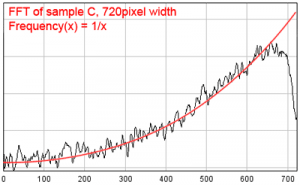

Så visst har du rätt att vara skeptisk (formlerna stämmer ju!), men resultaten du vill visa existerar tyvärr inte i den verklighet vi lever i idag. Den teoretiska modellen stämmer bra (eller iaf bättre) mot verkligheten först när man går till en nersampling högre än 4:1 i pixelförhållande, och även då får man en minskning av den totala signal/brus-nivån jämfört med den siffra man räknar fram - pga av att vi måste arbeta på interpolerade bilder. Hela pixelareor påverkas av enskilda pixlars signal/brus-värde när man Bayerinterpolerar, inte bara den enskilda pixeln. Om enskilda pixlar har en lägre användbar dynamik "sprider sig" alltså detta till större områden i bilden, och då gäller ju inte de strikt matematiska förutsättningarna per pixel längre.

Så... Teoretiskt sett har han rätt, men normalanvändaren har inget sätt att tillgodogöra sig denna "prestandalikvärdighet" just nu - det krävs bättre och betydligt mer avancerade verktyg än PhotoShop BiCubic i efterhand på en färdig, "framkallad", bild för det...

Men visst önskar jag att t.ex LightRoom (som jag tycker är bra rent användarmässigt/ergonomiskt) skulle implementera en alternativ inläsningsprocess för bilder som man

förvalt till att ha lägre upplösning! Detta hade varit fullständigt lysande, och gett betydligt bättre resultat än vad som är tillgängligt för höga ISO idag. Jag kan göra, och har gjort, jämförelser på alternativa CFA-interpoleringsmönster i MathCad, och man blir ordentligt imponerad av kvalitetsvinsterna som finns kvar att "krama ur" en sensor. Tyvärr blir man inte lika imponerad av tidsprestanda - jag är inte speciellt duktig på att knacka C#, så jag får hålla mig till MathCads högnivårutiner. En normal D700-raw tar då ca två minuter att konvertera... Plus meckandet innan med att manuellt "läsa ut" rawfilen till en linjär, ointerpolerad 16-bit gråvärdestif innan jag skickar vidare bilden till MathCad, plus att jag inte har något sätt att behålla Exif-informationen, plus, plus, plus osv... EN bild tar mig ca 20-30 minuter att "raw-konvertera" då. Men för ett mjukvaruföretag med lite resurser bakom hade det inte varit speciellt svårt att göra processen kortare/mer automatiserad...

Tyvärr finns kanske bara köpgruppen bland de professionella användarna - de flesta hobbyanvändare är mer imponerade av hur många pixlar en bild innehåller än hur pixlarna/bilden som helhet ser ut. Alltså är vinstmöjligheterna för investeringen i utvecklingen ganska skrala...