Install the app

How to install the app on iOS

Follow along with the video below to see how to install our site as a web app on your home screen.

Notera: This feature may not be available in some browsers.

Du använder en lite för gammal webbläsare, du bör uppdatera den.

Storlek och upplösning på TV

- Trådstartare Boris

- Start datum

Snapphaneledaren [E.F.S]

Aktiv medlem

En vanlig TV-bild kan maximalt hålla upplösningen 768 x 576 eller totalt ca 440 000 bildpunkter. Det räcker skärmen knappast till, men i praktiken ger heller inga TV-bilder riktigt den upplösningen. Det som sänds ut håller snarast omkring 330 000 bildpunkter.

I ett TV-rör brukar bildpunkterna vara omkring 0,7 mm stora. Mönstret blir alltså betydligt grövre mot en monitor, men en 28 tums skärm ger ändå rätt hög upplösning på ca 430 000 bildpunkter. Den är alltså betydligt sämre än en enkel datorskärm.

En liten 14 tums TV brukar märkligt nog ha ungefär lika grovt raster som 28-tummaren. Därmed får man betydligt lägre antal bildpunkter, eller bara omkring 100 000. En 14 tums TV är alltså normalt riktigt usel jämfört med en 14 tums datorskärm.

Men ändå kan alltså en TV återge VGA med rimligt gott resultat. Däremot klarar den knappast högre upplösningar alls.

Men det finns ytterligare en begränsning.

När man tittar på vanlig TV så finns de väsentligaste detaljerna i mitten på bilden. Det som sker i kanterna är inte lika viktigt. Samtidigt ställer man ofta in rätt hög ljusstyrka på TV:n för att kunna se i fullt dagsljus. Ofta orkar då elektroniken inte fokusera elektronstrålen lika bra i bildens kanter som i mitten. Bilden kan bli rätt suddig längst ut. Det gör inte så mycket om man ska se på vanliga TV-bilder.

I ett TV-rör brukar bildpunkterna vara omkring 0,7 mm stora. Mönstret blir alltså betydligt grövre mot en monitor, men en 28 tums skärm ger ändå rätt hög upplösning på ca 430 000 bildpunkter. Den är alltså betydligt sämre än en enkel datorskärm.

En liten 14 tums TV brukar märkligt nog ha ungefär lika grovt raster som 28-tummaren. Därmed får man betydligt lägre antal bildpunkter, eller bara omkring 100 000. En 14 tums TV är alltså normalt riktigt usel jämfört med en 14 tums datorskärm.

Men ändå kan alltså en TV återge VGA med rimligt gott resultat. Däremot klarar den knappast högre upplösningar alls.

Men det finns ytterligare en begränsning.

När man tittar på vanlig TV så finns de väsentligaste detaljerna i mitten på bilden. Det som sker i kanterna är inte lika viktigt. Samtidigt ställer man ofta in rätt hög ljusstyrka på TV:n för att kunna se i fullt dagsljus. Ofta orkar då elektroniken inte fokusera elektronstrålen lika bra i bildens kanter som i mitten. Bilden kan bli rätt suddig längst ut. Det gör inte så mycket om man ska se på vanliga TV-bilder.

Michael Johansson

Aktiv medlem

sagan skrev:

Givetvis är det bättre att skanna in i betydligt högre upplösning för att sen göra bilderna i "rätt" storlek.

Nu blev jag nyfiken. Varför är det bättre att scanna in en bild i större upplösning än vad som skall användas (på TV i detta fall). Det betyder väl att bilden sedermera måste interpoleras till annan storlek och det kan väl inte förbättra bildkvalitén? eller...?

Loj

Aktiv medlem

Det var ju en snabb slutsats. Var kom den ifrån?mganga skrev:

Kontentan var väl att det inte blir bra, helt enkelt, på en TV.

Det hela beror förstås vad man menar med "bra". Om "bra" är högsta möjliga tillgängliga bildkvalitet har du förmodligen rätt. (Fast med det måttet mätt är det inte mycket som "duger".) Men om "bra" innebär hyfsad bildkvalitet och även inkluderar faktorer som lättillgänglighet och möjlighet att på en enkelt sätt presentera multimedialt bildspel, då anser jag att din slutsats är fel.

mvh Janne

Senast ändrad:

Michael Johansson

Aktiv medlem

sagan skrev:

Om du trycker ihop en bild med högre upplösning så ger det bättre bildkvalitet, än om du tar en bild som har en låg upplösning från början..testa så får du se.

Men...

Om jag skall visa en bild i 640*480 punkter och scannar den i denna upplösning borde väl det bli bättre än att scanna i vad-som-helst-större upplösning och därefter förminska/interpolera till en mindre upplösning.

mganga

Aktiv medlem

Loj skrev:

Det var ju en snabb slutsats. Var kom den ifrån?

Det hela beror förstås vad man menar med "bra". Om "bra" är högsta möjliga tillgängliga bildkvalitet har du förmodligen rätt. (Fast med det måttet mätt är det inte mycket som "duger".) Men om "bra" innebär hyfsad bildkvalitet och även inkluderar faktorer som lättillgänglighet och möjlighet att på en enkelt sätt presentera multimedialt bildspel, då anser jag att din slutsats är fel.

mvh Janne

Jag har aldrig upplevt stillbilder på tv som bra. Det finns flera faktorer. Förutom det Patrik tog upp, som t ex varierande reell upplösning och skärpa har vi ofta en dålig uppdateringsfrekvens vilket också ger flimmer och färginställning. Men smaken är som baken

Michael Johansson

Aktiv medlem

Nä-hä

Snapphaneledaren [E.F.S]

Aktiv medlem

sagan skrev:

Om du trycker ihop en bild med högre upplösning så ger det bättre bildkvalitet, än om du tar en bild som har en låg upplösning från början..testa så får du se.

Det är ju inte ett riktigt påstående, jag har alltid lärt mig att man ska scanna för den upplösningen man ska använda bilden till, av den anledningen att om du plockar bort information för att du har scannat i hög upplösning och då kommer t ex linjer försvinna eller förvrängas.

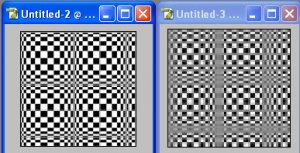

Test med att göra en högupplöst bild med en massa tunna linjer och sedan förminskar. Här är ett utsnitt av samma bild, men den andra bilden hade en högre upplösning som sedan förminskades till samma storlek som den första.

Bilagor

Snapphaneledaren [E.F.S]

Aktiv medlem

För att svara på din fråga så tycker jag att du är på rätt spår. Det är bättre att scanna in bilden för den upplösning du ska använda den till ( i detta fall 640*480 ) och du vinner en hel del i både snabbhet vid scanning och sedan vid visning än att använda en högupplöst bild.

Ska du scanna in en bild för arkivering så är det en helt annan sak, då vet du inte vad du kommer att använda bilden till i framtiden och då är det bättre att scanna in bilden högupplöst eftersom det blir oftast bättre att göra ett mindre format från ett större än tvärtom. Men eftersom du kommer att behålla negativet/positivet och inte slänga det efter scanningen så kan du ju alltid göra en ny scanning, neg/pos blir ju inte sämre men scanners blir bara bättre och bättre.

Ska du scanna in en bild för arkivering så är det en helt annan sak, då vet du inte vad du kommer att använda bilden till i framtiden och då är det bättre att scanna in bilden högupplöst eftersom det blir oftast bättre att göra ett mindre format från ett större än tvärtom. Men eftersom du kommer att behålla negativet/positivet och inte slänga det efter scanningen så kan du ju alltid göra en ny scanning, neg/pos blir ju inte sämre men scanners blir bara bättre och bättre.

Michael Johansson

Aktiv medlem

Snapphaneledaren skrev:

Men eftersom du kommer att behålla negativet/positivet och inte slänga det efter scanningen så kan du ju alltid göra en ny scanning, neg/pos blir ju inte sämre men scanners blir bara bättre och bättre.

Nä nu blommar asfalten!

Nog har jag alltid hört att film åldras, speciellt färgfilm. Visserligen går det att minska åldringshastigheten, men inte helt eliminera den. Det betyder att den scannade bilden i hög upplösning bör bli förhållandevis bättre med tiden (jämfört med det åldrade filmoriginalet). Tänk på färgförändringar och angrepp av microorganismer och mögel. Det förutsätter förståss att det digitala lagringsmediet är hållbart eller underhålles med regelbundna backuper samt att, som du inleder med, scannar i bra upplösning och färgdjup.

nysteanders

Aktiv medlem

Snapphaneledaren skrev:

En vanlig TV-bild kan maximalt hålla upplösningen 768 x 576 eller totalt ca 440 000 bildpunkter. Det räcker skärmen knappast till, men i praktiken ger heller inga TV-bilder riktigt den upplösningen. Det som sänds ut håller snarast omkring 330 000 bildpunkter.

I ett TV-rör brukar bildpunkterna vara omkring 0,7 mm stora. Mönstret blir alltså betydligt grövre mot en monitor, men en 28 tums skärm ger ändå rätt hög upplösning på ca 430 000 bildpunkter. Den är alltså betydligt sämre än en enkel datorskärm.

En liten 14 tums TV brukar märkligt nog ha ungefär lika grovt raster som 28-tummaren. Därmed får man betydligt lägre antal bildpunkter, eller bara omkring 100 000. En 14 tums TV är alltså normalt riktigt usel jämfört med en 14 tums datorskärm.

Men ändå kan alltså en TV återge VGA med rimligt gott resultat. Däremot klarar den knappast högre upplösningar alls.

Men det finns ytterligare en begränsning.

När man tittar på vanlig TV så finns de väsentligaste detaljerna i mitten på bilden. Det som sker i kanterna är inte lika viktigt. Samtidigt ställer man ofta in rätt hög ljusstyrka på TV:n för att kunna se i fullt dagsljus. Ofta orkar då elektroniken inte fokusera elektronstrålen lika bra i bildens kanter som i mitten. Bilden kan bli rätt suddig längst ut. Det gör inte så mycket om man ska se på vanliga TV-bilder.

PAL-systemet som vi använder i Europa använder 625 linjer horisontellt, varav ca 575 är "aktiva linjer", dvs synliga på skärmen. USA använder NTSC-systemet och där är motsvarande 525 linjer varav ca 475 är synliga.

I båda systemen är en linje 720 pixlar på en 4:3-TV.

Utmärkt mer detaljerad info om detta finns här

Hur stora pixlarna är (i mm) beror givetvis på TV-rutans storlek. Oavsett om Du har en 14" eller 32" TV så innehåller insignalen 625 linjer (i Europa alltså). Det är därför som man i allmänhet upplever en mindre TV-bild som skarpare än en stor på samma avstånd. Men att rastret skulle vara "för grovt" på en 14" köper jag inte riktigt. Vissa tillverkare (Sony, Mitsubishi) använder ju en helt annan teknik (Trinitron, DiamondTron) där skuggmasken ser helt annorlunda ut, med spalter istället för punkter, så jag skulle inte påstå att detta är sant generellt.

Hursomhelst: 625x720 är alltså en väl tilltagen upplösning som Du kan vara säker på att TV:n "inte är bättre än".

Snapphaneledaren [E.F.S]

Aktiv medlem

Michael Johansson skrev:

Nä nu blommar asfalten!

Nog har jag alltid hört att film åldras, speciellt färgfilm. Visserligen går det att minska åldringshastigheten, men inte helt eliminera den. Det betyder att den scannade bilden i hög upplösning bör bli förhållandevis bättre med tiden (jämfört med det åldrade filmoriginalet). Tänk på färgförändringar och angrepp av microorganismer och mögel. Det förutsätter förståss att det digitala lagringsmediet är hållbart eller underhålles med regelbundna backuper samt att, som du inleder med, scannar i bra upplösning och färgdjup.

Men snälla du, jag tror dock att film åldras saktare än teknikframgången på en scanner. Jag har 17 år gamla negativ som är precis lika bra som dom jag tog för ett år sedan om man bortser från att film även har gjort stora framsteg. Kan inte påstå att jag kan säga detsamma om scanners även om asfalten blommar eller ej. Du får ju sätta saker i perspektiv, detta är ingen debatt över digtalt mot analogt.

sagan

Avslutat medlemskap

Snapphaneledaren skrev:

Det är ju inte ett riktigt påstående, jag har alltid lärt mig att man ska scanna för den upplösningen man ska använda bilden till, av den anledningen att om du plockar bort information för att du har scannat i hög upplösning och då kommer t ex linjer försvinna eller förvrängas.

Test med att göra en högupplöst bild med en massa tunna linjer och sedan förminskar. Här är ett utsnitt av samma bild, men den andra bilden hade en högre upplösning som sedan förminskades till samma storlek som den första.

Jag tycker inte det är någon som helst tvekan om att bilden ser betydligt bättre ut om man förminskar den från en större bild, jämfört med att skanna direkt i den mindre storleken.

Både skärpan/detaljåtergivningen och kornen ser betydligt bättre ut.

Snapphaneledaren [E.F.S]

Aktiv medlem

anders_eriksson skrev:

PAL-systemet som vi använder i Europa använder 625 linjer horisontellt, varav ca 575 är "aktiva linjer", dvs synliga på skärmen. USA använder NTSC-systemet och där är motsvarande 525 linjer varav ca 475 är synliga.

I båda systemen är en linje 720 pixlar på en 4:3-TV.

Utmärkt mer detaljerad info om detta finns här

Hur stora pixlarna är (i mm) beror givetvis på TV-rutans storlek. Oavsett om Du har en 14" eller 32" TV så innehåller insignalen 625 linjer (i Europa alltså). Det är därför som man i allmänhet upplever en mindre TV-bild som skarpare än en stor på samma avstånd. Men att rastret skulle vara "för grovt" på en 14" köper jag inte riktigt. Vissa tillverkare (Sony, Mitsubishi) använder ju en helt annan teknik (Trinitron, DiamondTron) där skuggmasken ser helt annorlunda ut, med spalter istället för punkter, så jag skulle inte påstå att detta är sant generellt.

Hursomhelst: 625x720 är alltså en väl tilltagen upplösning som Du kan vara säker på att TV:n "inte är bättre än".

Det är iofs länge sedan jag höll på med att rep. tv och det kommer nya saker hela tiden men om du nu ska klyva hårstrår så kan du ju inte själv säga att alla tv apparater visar 575 synliga linjer för det finns dom som visar färre och dom som visar fler.

Och om du inte tror mig om rastret så får du väl räkna dom.... En billig damstrumpa uppspänt på en ram borde fortfarande fungera.... Jag kan ha fel om dagens tv, men eftersom jag inte fick reda på märke, modell, ålder, hur den är inställd osv så är det svårt att komma med ett svar som stämmer över alla tv apparater som någonsin har tillverkats och som är kortare än en doktorsavhandling. Vet att t ex Dr Seufert skärmar kunde visa i stortsett hela rastert från kant till kant, men dom var också jätte ömtåliga eftersom det var ett special material för att göra dom lättare så att man skulle kunna limma dom istället för att ha som en vanlig tv en ram runt, då man kunde sätta ihop flera stycken till en stor skärm...

Boris

Aktiv medlem

Jag tänkte mer så här, om jag ska nu visa bilder på datorns skärm över hela ytan så scannar jag de ex. i storlek 1024x768 pixlar med 72 dpi.

Om jag vill utnytja max. storlek på TV(57x32cm)

ska jag inte scanna då in bilden så att slut resultat blir 57x32cm med 72 dpi?

Eller hur många dpi klarar av TV?

Om jag vill utnytja max. storlek på TV(57x32cm)

ska jag inte scanna då in bilden så att slut resultat blir 57x32cm med 72 dpi?

Eller hur många dpi klarar av TV?

Similar threads

- Svar

- 6

- Visningar

- 1 K

- Svar

- 38

- Visningar

- 4 K

- Svar

- 22

- Visningar

- 3 K