JazzBass

Aktiv medlem

Jag tycker att bilden jag lade upp en bit bakåt i tråden visar hur förbaskat enkelt det här egentligen är. DX är som en beskärning av FX, punkt slut. Objektivet skickar bara en bild med sina specifika egenskaper (bildvinkel, skärpedjup...) bakåt mot sensorn, så den enda skillnaden man får mellan DX och FX är en skillnad i utsnitt. Sen förstoras förstås DX-bilden ungefär dubbelt mer för att kompensera för den mindre sensorn, då den visas i samma fysiska storlek på skärmen eller utskriven i viss storlek. Kvalitetsförlusterna för DX jämfört med FX har så gott som enbart att göra med denna dubbla förstoring av DX-bilden. Jämför man t.ex. en FX-bild utskriven på A3 med en DX-bild på A4, hittar man nog väldigt lite skillnader vad gäller skärpa och brusegenskaper.

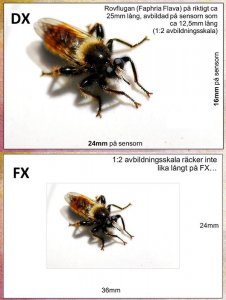

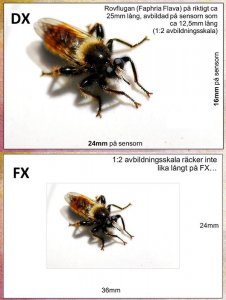

DX ger på grund av beskärningsfaktorn också en dubbelt högre skenbar avbildningsskala än FX, alltså motivet ser dubbelt större ut på DX än FX vid samma faktiska avbildningsskala, se bifogad bild. Ju högre avbildningsskala, desto mindre bländare måste man använda för att få ett visst skärpedjup.

Vill man ta ekvivalenta bilder måste man med FX använda 1,5x längre brännvidd än på DX för samma bildvinkel, vilket ökar förstoringsgraden och därmed minskar skärpedjupet. Det måste man kompensera för i sin tur genom att blända ner ett steg mer. Den ljusförlusten kompenserar man för genom att höja iso ett steg. Totalt sett samlas då lika mycket ljus och information, så bilderna blir likvärdiga.

DX ger på grund av beskärningsfaktorn också en dubbelt högre skenbar avbildningsskala än FX, alltså motivet ser dubbelt större ut på DX än FX vid samma faktiska avbildningsskala, se bifogad bild. Ju högre avbildningsskala, desto mindre bländare måste man använda för att få ett visst skärpedjup.

Vill man ta ekvivalenta bilder måste man med FX använda 1,5x längre brännvidd än på DX för samma bildvinkel, vilket ökar förstoringsgraden och därmed minskar skärpedjupet. Det måste man kompensera för i sin tur genom att blända ner ett steg mer. Den ljusförlusten kompenserar man för genom att höja iso ett steg. Totalt sett samlas då lika mycket ljus och information, så bilderna blir likvärdiga.