Martin Chab

Aktiv medlem

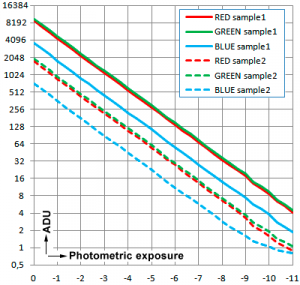

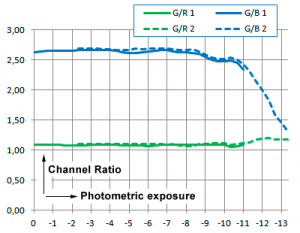

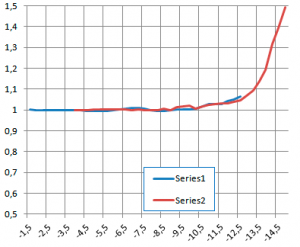

Objektiv kan aldrig lägga till DR. Det de ALLTID gör är att ta bort DR. Ströljuset, dvs summan av diffraktion, reflexer, interna imperfektioner och föroreningar i glaset, ojämnheter i antireflex-beläggningen osv gör att den mörkaste punkten i bilden i ett "normalmotiv" aldrig kan bli mycket mörkare än 13-14Ev under den ljusaste punkten.

Även om motivet i verkligheten, framför objektivet, har ett omfång på 20Ev kan detta aldrig "passera igenom" objektivet ostört.

Du kan inte prata om DR över huvud taget om du inte sätter det i relation till minst två saker - omständigheter då det mäts samt om det är mål-DR eller bild-DR.

För övrigt är latitud en helt separat fråga. Vad det gäller film har det kommit två specialfilmer på senare år som har bra DR. Annars har film riktigt DÅLIG DR. Att film har bra latitud, dvs att man kan flytta omfånget uppåt eller neråt utan att klippa för hör hårt är en annan sak, men i en enskild bild har de flesta färgfilmer runt 9Ev DR. Fyra helsteg sämre än en normalbra digital sensor idag.

well put!!