stefohl

Aktiv medlem

Min lilla spydighet var inte riktad till dig

OK, men jag tror att även Mikael drivs av samma vilja.

Inga problem med att svara på det.Det är ju såklart så som du säger att antalet bitar "i skärmen" inte har med dynamiken att göra utan med upplösningen av tonerna. Borde ha tänkt efter före.

Den situationen löser jag allt oftare med hjälp av HDR. Även på frihand går det att ta en snabb serie på 3-5 bilder som sedan Photoshop kan lägga samman med pixelpassning. I CS5 har också HDR-konverteringen blivit mycket bättre. En bra HDR-bild behöver inte skrika HDR längre, utan man får bara bilder med ett större kontrastomfång. Men vi är nog alla eniga om att ett större kontrastomfång vore bättre.De bilder där jag oftast råkar ut för att dynamiken inte räcker till är när jag fotograferar i tex. en stad med höga hus som skuggar och en bit ljus himmel någonstans i bilden. Om jag då exponerar så att himlen precis inte blir överexponerad så är skuggorna allt för mörka och svåra att lätta upp utan att bruset blir störande.

Som jag sade tidigare så brukar jag rädda en sådan bild genom att låta himlen bli överexponerad och sedan göra en svartvit bild. Då kan jag antingen låta himlen förbli överexponerad, det stör inte lika mycket i en svartvit bild, eller så kan jag göra det överexponerade partiet mörkare vilket funkar i en svartvit bild men inte i en färgbild, tycker jag.

Fördelen med filmens s-formade kurva är att du slipper det abrupta övergången mellan normalt exponerad och överexponerad bild. Nackdelen är att du komprimerar tonerna allt mer ju mer du överexponerar. Att man sedan oftast lägger på en S-formad kurva vid råkonverteringen är ju bara för att vi ser att bilderna får en bättre separation i mellantonerna. Den sämre kontrasten i hög- och lågdagrar är vi beredda att offra för att få den bättre separationen i mellantonerna.Jag har fler frågor där du kanske kan hjälpa mig nu när diskussionen ändå är igång. Utsignalen från en CMOS-sensor är väl linjär i förhållande till det infallande ljuset medan en analog film har en S-formad känslighetskurva (rätt, fel?). Detta måste väl göra stor skillnad i hur film respektive CMOS-sensorer hanterar högdagrar och skuggor. Jag tycker spontant att det borde vara bättre att ha en S-formad känslighetskurva än en linjär, ett plus för film alltså. Jag har för mig att det finns någon inställning i min kamera som försöker simulera detta, högdagerprioritet tror jag att det kallas..

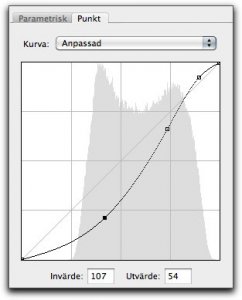

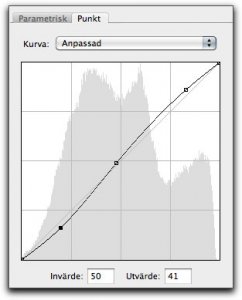

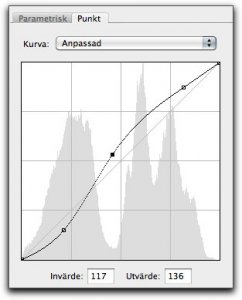

Men den stora fördelen för råformatet är att jag kan anpassa denna kurva optimalt för olika bildtyper. För ljusa bilder en S-kurva med brant lutning i de ljusaste partierna, för mörka bilder så gör jag en kurva som separerar skuggor bra. Här ser du en kurva först för ljusa bilder, sedan normala och till slut för mörka bilder.